| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- Ethereum

- pyspark

- web3@1.2.8

- word count

- lambda

- MAP

- bigdata

- Greeter

- OpenCV

- solidity

- macbook

- nodejs

- jenv

- apache-spark

- python3

- HelloWorld

- BlockChain

- stopwords

- node

- geth

- 블록체인

- 이더리움

- Histogram

- docker

- Spark

- Apache Spark

- remix

- Python

- RDD

- web3

- Today

- Total

이것저것 프로그래밍 정리(Macbook)

apache-spark@3.0.1 설치 본문

spark 3.0.1 버전이 나왔습니다.

이번 글에서는 spark 3.0.1 버젼 설치법에 대해 알아보겠습니다.

기본적으로 아랫글 spark@2.4.4 와 유사합니다.

apache-spark 시작하기(Macbook), spark 설치

스파크 사용 이유는? 먼저 데이터가 엄청난 양으로 증가되며, 이를 처리하기 위해 분산 프레임워크인 Hadoop과 최근에 Spark가 많이 쓰이고 있다. Hadoop은 데이터를 수집하는 목적으로 많이 사용된��

parkaparka.tistory.com

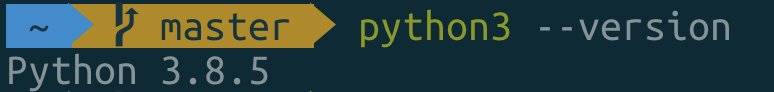

이전 spark 버전은 python@2가 사용 가능했지만 spark@3.0.0 부터는 python@3만 사용 가능합니다.

먼저 python3를 brew를 통해 설치해 주겠습니다.

brew install python3

현재 9월 16일 기준으로 python 3.8.5 버젼이 설치됩니다.

또한 spark 3.0.0에는 java11이 호환이 잘 된다고 합니다.

jenv 설치 및 사용법,jenv 를 이용한 Macbook java 버젼 관리하기

Jenv 여러가지 버젼의 자바가 나오고 있지만 많은 프레임워크와 라이브러리에서 Java8이 최적화 되어있습니다. 따라서 Jenv를 통해서 여러가지 버젼의 Java를 활용하는 방법을 알아보겠습니다. Adopto

parkaparka.tistory.com

다음 글을 참고해서 java11을 설치해 주시기 바랍니다.

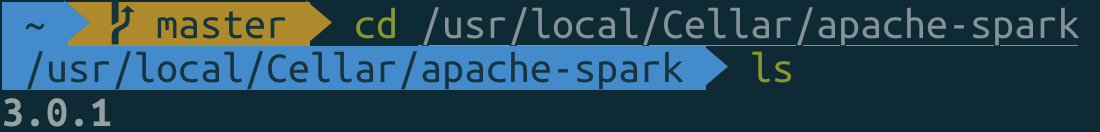

터미널에서 brew를 통해서 spark를 설치해주겠습니다.

brew install apache-spark

이후에 spark 의 경로 설정을 해주겠습니다.

저같은 경우에 zsh을 쓰기 때문에 ~/.zshrc 에서 경로설정을 해주겠습니다. bash를 쓰시는 분들은 ~/.bashrc, ~/.bash_profile에서 설정해 주시면 되겠습니다.

/usr/local/Cellar/apache-spark 폴더를 들어가 보면 아래 사진과 같이 해당 spark의 버전이 써져 있습니다.

3.0.1 버전이기 때문에 3.0.1 이라 하였고 버전이 다른 분들은 해당 버전을 입력하시면 되겠습니다.

위의 변수를 환경변수 설정 해주면 spark의 환경변수 설정이 끝났습니다.

이후 spark에서 python3를 통해 pyspark를 사용하기 위하여 변수를 설정해 주도록 하겠습니다.

또한 터미널 환경이 아닌 jupyter notebook을 활용하기 위해 이것도 함께 ~/.zshrc 에서 함께 설정해 주도록 하겠습니다.

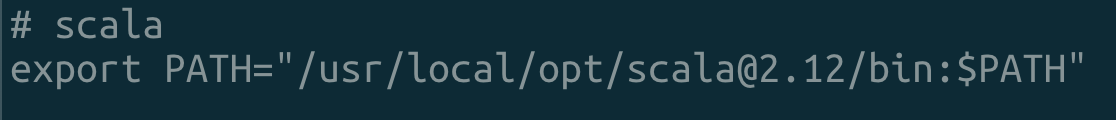

Scala 설치

scala는 @2.12 버젼을 설치해주도록 하겠습니다.

brew install scala@2.12

위 명령어를 통해 scala@2.12를 설치해줍니다.

이후 ~/.zshrc 에 scala 환경변수를 다음과 같이 설정해줍니다.

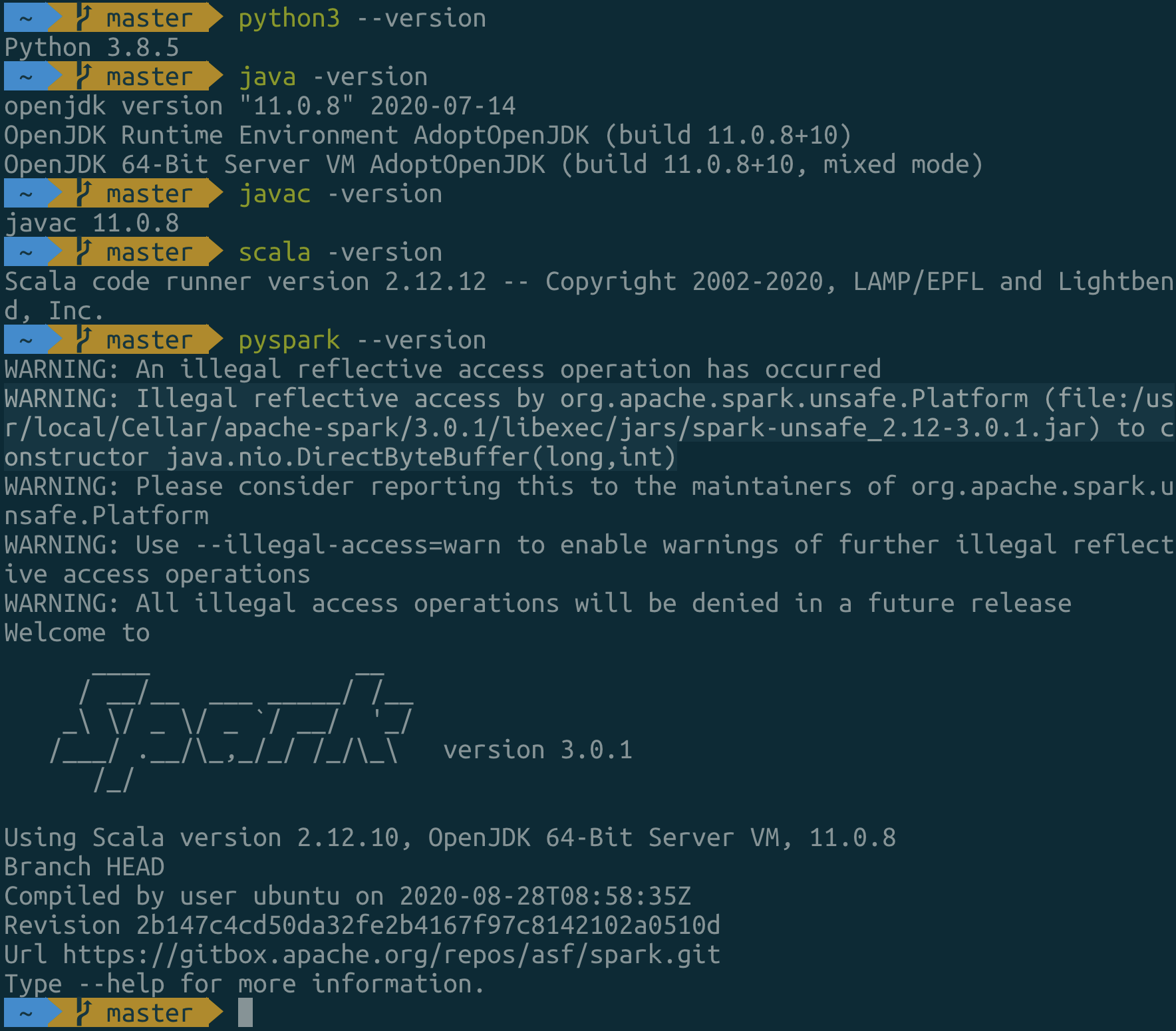

이제는 설치한 것들 버젼을 확인해주도록 하겠습니다.

여기까지 오류 없이 뜨시면 pyspark를 치면 python3를 통해 spark@3.0.1 을 사용할 수 있습니다.

scala를 통해서 spark를 이용하실 분들은 spark-shell을 터미널에 입력하면 사용할 수 있습니다.

ERROR

WARN Utils: Service 'sparkDriver' could not bind on a random free port. You may check whether configuring an appropriate binding address.

다음과 같은 오류가 뜨시는 분들도 있을 겁니다.

그럼 pyspark 대신 맨 처음에 한번 아래 명령어로 pyspark를 틀어주면 error가 해결되고 pyspark가 정상 작동 할 겁니다.

pyspark -c spark.driver.bindAddress=127.0.0.1

'apache-spark(big data)' 카테고리의 다른 글

| apache-spark ML을 이용한 Logistic Regression - pyspark (0) | 2020.12.22 |

|---|---|

| pip에서 pyspark 라이브러리 설치해서 이용하기 (2) | 2020.12.10 |

| apache-spark의 Dataframe(1) - pyspark (0) | 2020.04.29 |

| apache-spark 에서 word count하기(2) - pyspark (0) | 2020.04.28 |

| apache-spark 에서 word count하기(1) - pyspark (0) | 2020.04.27 |